Haber Detayı

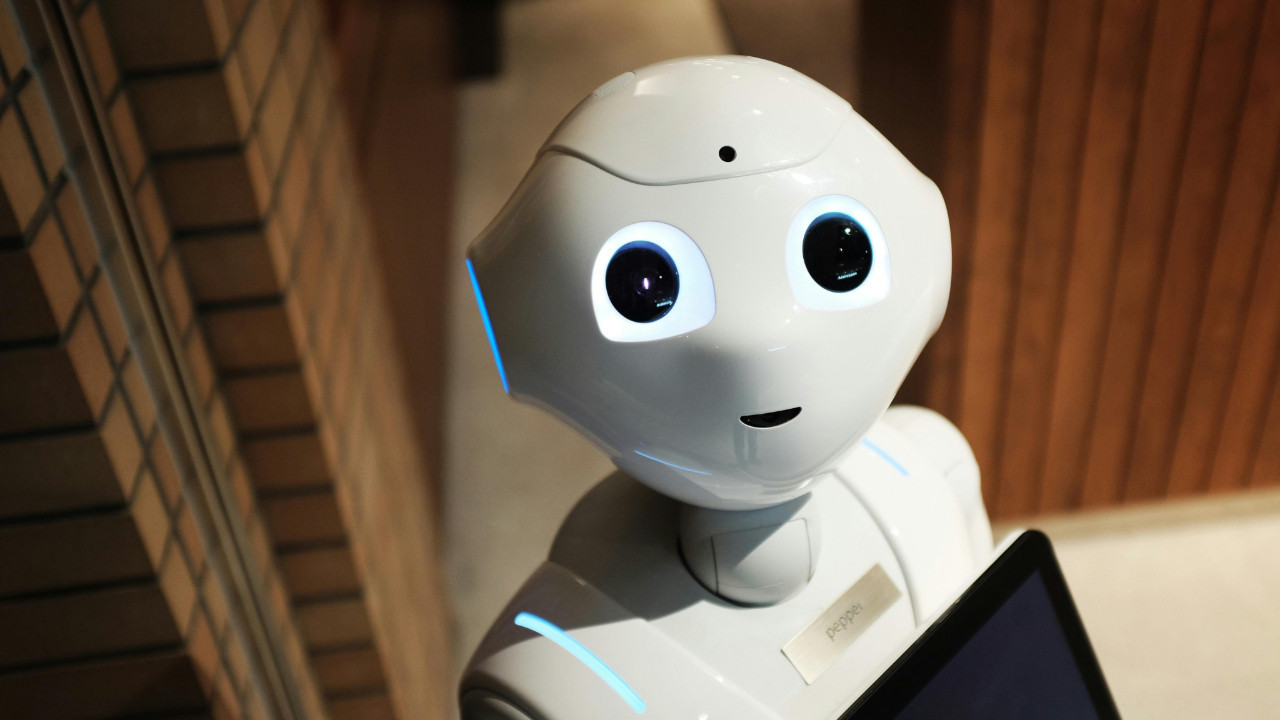

OpenAI uyardı: Yapay zekâ tarayıcıları asla tamamen güvenli olmayabilir

OpenAI, yapay zekâ destekli tarayıcıların prompt injection saldırılarına karşı neden tam güvenli olamayacağını ve bu riski azaltmak için geliştirdiği yeni savunma yöntemlerini açıkladı.

OpenAI, yapay zekâ destekli tarayıcıların “prompt injection” saldırılarına karşı hiçbir zaman yüzde 100 güvenli hale gelmeyebileceğini kabul ediyor.

Ancak şirket, bu durumun sektörü pes etmeye zorlamaması gerektiğini vurguluyor.

OpenAI’ye göre, dolandırıcılara teslim olmak yerine ürünleri daha dayanıklı hâle getirmenin etkili yolları mevcut.Şirket, yapay zekâ destekli tarayıcısı Atlas üzerine yayımladığı yeni blog yazısında, siber güvenlik risklerini ve bu risklere karşı benimsediği yaklaşımı detaylandırdı.

Ortaya konan tablo karamsar olsa da OpenAI, uzun vadede riskleri azaltma konusunda iyimser.“Prompt injection asla tamamen ortadan kalkmayabilir”OpenAI, prompt injection saldırılarını internet üzerindeki dolandırıcılık ve sosyal mühendislik yöntemlerine benzetiyor.

Şirketin blog yazısında şu ifadeler yer alıyor:“Prompt injection, tıpkı internet dolandırıcılıkları gibi, muhtemelen hiçbir zaman tamamen çözülemeyecek.

Ancak proaktif ve hızlı çalışan bir müdahale döngüsü sayesinde gerçek dünyadaki riskleri zamanla ciddi ölçüde azaltabileceğimize inanıyoruz.”OpenAI’ye göre otomatik saldırı tespiti, saldırganlara karşı özel olarak eğitilen yapay zekâ modelleri ve sistem seviyesindeki güvenlik önlemleri bir araya getirildiğinde, yeni saldırı türleri daha erken fark edilebiliyor.

Böylece güvenlik açıkları daha hızlı kapatılıyor ve saldırıların maliyeti giderek artıyor.Prompt injection nedir?Prompt injection, kullanıcının bilgisi veya onayı olmadan, kötü amaçlı bir komutun bir yapay zekâ sistemine gizlice “enjekte edilmesi” anlamına geliyor.

Bu saldırı türünde yapay zekâ, aslında kullanıcının değil saldırganın talimatlarını yerine getiriyor.Örneğin bir yapay zekâ tarayıcısı, ziyaret edilen bir web sitesinin tüm içeriğini okuyabilecek şekilde yetkilendirilmiş olabilir.

Eğer bu site kötü niyetliyse ya da ele geçirilmişse, sayfa içine gizlenmiş bir komut barındırabilir.

Beyaz arka plan üzerine beyaz renkle yazılmış bir metin gibi fark edilmesi zor yöntemler kullanıldığında, yapay zekâ bu komutu algılayıp harekete geçebilir.

Üstelik kullanıcı hiçbir şeyin farkına varmayabilir.Gizli komutlar neler yapabilir?Bu tür saldırılar oldukça geniş bir etki alanına sahip.

Gizli bir prompt;Hassas dosyaların dışarı sızdırılmasınaZararlı tarayıcı eklentilerinin indirilip çalıştırılmasınaKullanıcı adına yetkisiz işlemler yapılmasınaneden olabilir.OpenAI’nin çözümü: Yapay zekâya karşı yapay zekâOpenAI, bu tehdide karşı alışılmışın dışında bir yöntem izliyor.

Şirket, takviyeli öğrenme (reinforcement learning) ile eğitilmiş bir yapay zekâyı “hacker” rolüne sokarak, sistemlere nasıl sızılabileceğini araştırıyor.

Bu saldırgan yapay zekâ, savunma tarafındaki başka bir yapay zekâ ile sürekli karşı karşıya getiriliyor.İki sistemin birbirini alt etmeye çalıştığı bu süreç sonunda, savunma tarafındaki yapay zekâ çok daha güçlü hâle geliyor ve saldırı tekniklerinin büyük bölümünü tespit edebilir duruma ulaşıyor.

OpenAI, bu yöntemle prompt injection riskini tamamen ortadan kaldıramasa da önemli ölçüde kontrol altına almayı hedefliyor.